Bard, rival do ChatGPT, é treinado por humanos mal pagos, sobrecarregados e frustrados

Documentos internos obtidos pela Bloomberg mostram que funcionários terceirizados recebem instruções complexas para revisar chatbot em prazos exíguos, criando risco de imprecisões

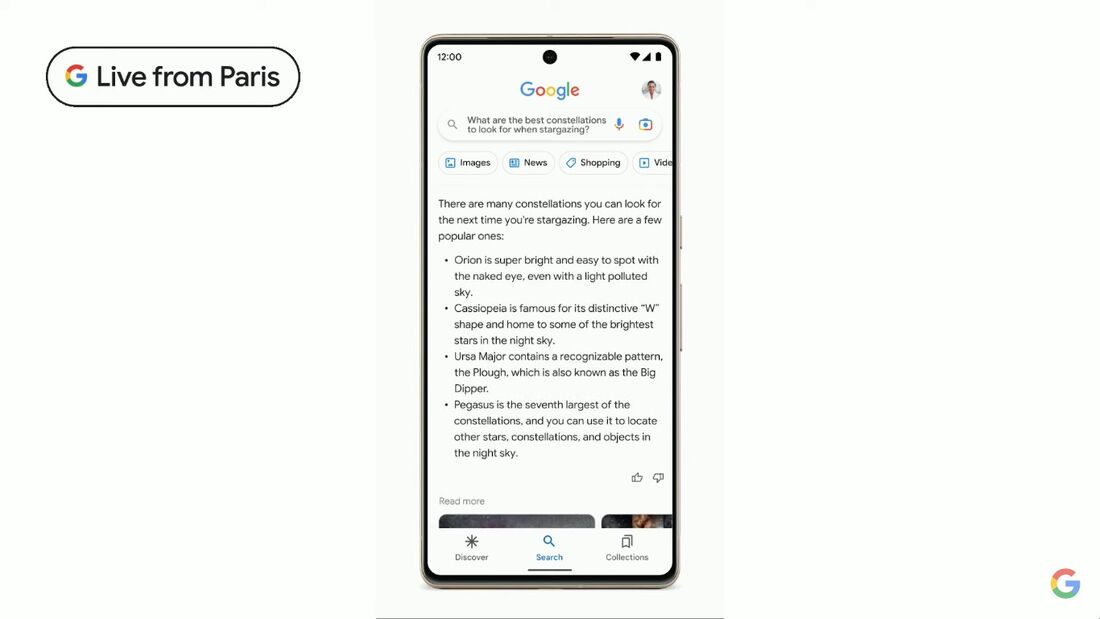

O Bard, chat de inteligência artificial do Google rival do CHatGPT, pode te responder em segundos a perguntas tão variadas como, por exemplo, quantos pandas vivem hoje em zoológicos no mundo.

A garantia de que a resposta seja bem fundamentada e baseada em evidências fica a cargo de milhares de prestadores de serviços externos de empresas como a Appen e a Accenture, que muitas vezes ganham muito pouco e atuam com treinamento mínimo e prazos frenéticos.

Documentos obtidos pela agência de notícias Bloomberg e relatos de funcionários - que pediram anonimato - mostram uma rotina de trabalho extenuante. Muitos ganham apenas US$ 14 por hora. E precisam cumprir, em prazos exíguos - às vezes, apenas três minutos - checagens de temas complexos, como a dosagem de um medicamento.

Esses prestadores de serviços são o suporte invisível do boom da IA generativa que chegou para mudar o mundo. Chatbots como o Bard usam inteligência computacional para responder quase instantaneamente a uma série de consultas que abrangem todo o conhecimento e a criatividade humana.

Mas, para aprimorar essas respostas de modo que possam ser fornecidas de forma confiável repetidas vezes, as empresas de tecnologia dependem de pessoas reais que revisam as respostas, fornecem feedback sobre os erros e eliminam qualquer indício de parcialidade.

Leia também

• Conheça Claude, rival do ChatGPT que acaba de ganhar nova versão da Anthropic, startup de IA

• Inteligência artificial "influencia sobretudo na qualidade dos empregos" até agora, diz OCDE

• Inteligência Artificial: ONU frente ao despertar dos robôs

É um trabalho cada vez mais ingrato. Seis atuais funcionários terceirizados do Google disseram que, à medida que a empresa entrou em uma "corrida armamentista" de IA com a rival OpenAI no ano passado, o tamanho de sua carga de trabalho e a complexidade de suas tarefas aumentaram.

Sem conhecimentos específicos, eles foram encarregados de avaliar respostas em assuntos que variavam de doses de medicamentos a leis estaduais. Os documentos compartilhados com a Bloomberg mostram instruções complicadas que os funcionários devem aplicar às tarefas com prazos para auditar as respostas que podem ser muito curtos, às vezes de apenas três minutos.

- Da forma como está agora, as pessoas estão assustadas, estressadas, mal pagas e não sabem o que está acontecendo. E essa cultura de medo não é propícia para obter a qualidade e o trabalho em equipe que se deseja de todos nós - disse um dos contratados.

O Google posicionou seus produtos de IA como recursos públicos na saúde, na educação e na vida cotidiana. Mas, privada e publicamente, os contratados levantaram preocupações sobre suas condições de trabalho, que, segundo eles, prejudicam a qualidade do que os usuários veem.

Risco de virar um produto defeituoso e perigoso

Um funcionário contratado do Google que trabalha para a Appen disse, em uma carta enviada ao Congresso em maio, que a velocidade com que eles são obrigados a revisar o conteúdo pode fazer com que o Bard se torne um produto "defeituoso" e "perigoso".

O Google fez da IA uma grande prioridade em toda a empresa, apressando-se em inserir a nova tecnologia em seus principais produtos após o lançamento do ChatGPT, criado pela OpenAI em novembro passado.

Em maio, na conferência anual de desenvolvedores I/O da empresa, o Google abriu o Bard para 180 países e territórios e revelou recursos experimentais de inteligência artificial em produtos de destaque, como pesquisa, e-mail e Google Docs. O Google se posiciona como superior à concorrência devido ao seu acesso à "amplitude do conhecimento mundial".

"Realizamos um trabalho extenso para desenvolver nossos produtos de IA de forma responsável, incluindo testes rigorosos, treinamento e processos de feedback que aperfeiçoamos durante anos para enfatizar a factualidade e reduzir vieses", disse o Google, de propriedade da Alphabet, em um comunicado.

A empresa disse que não está contando apenas com os avaliadores para aprimorar a IA, e que há vários outros métodos para melhorar sua precisão e qualidade.

Para se preparar para o uso desses produtos pelo público, os funcionários disseram que começaram a receber tarefas relacionadas à IA já em janeiro. Os funcionários também são frequentemente solicitados a determinar se as respostas do modelo de IA contêm evidências verificáveis.

Revisão baseda em "rápida pesquisa na web"

Os avaliadores são solicitados a decidir se uma resposta é útil com base em diretrizes de seis pontos que incluem a análise das respostas quanto a aspectos como especificidade, atualidade das informações e coerência.

Também é solicitado que eles se certifiquem de que as respostas não "contenham conteúdo nocivo, ofensivo ou excessivamente sexual" e não "contenham informações imprecisas ou enganosas". O levantamento das respostas da IA quanto a conteúdo enganoso deve ser "baseado em seu conhecimento atual ou em uma rápida pesquisa na web", dizem as diretrizes, que apontam ainda que . "não é necessário realizar uma verificação rigorosa dos fatos" ao avaliar a utilidade das respostas.

O exemplo de resposta para "Quem é Michael Jackson?" incluía uma imprecisão sobre o fato de o cantor ter estrelado o filme "Moonwalker", que a IA dizia ter sido lançado em 1983. Na verdade, o filme foi lançado em 1988.

"Embora seja comprovadamente incorreto", afirmam as diretrizes, "esse fato é insignificante no contexto da resposta à pergunta "Quem é Michael Jackson?"

Mesmo que a imprecisão pareça pequena, "ainda é preocupante que o chatbot esteja errando os principais fatos", disse Alex Hanna, diretor de pesquisa do Distributed AI Research Institute e ex-especialista em ética de IA do Google:

- Essas ferramentas parecerão estar fornecendo detalhes que estão corretos, mas não estão.

Os avaliadores dizem que estão verificando tópicos de alto risco para os produtos de IA do Google. Um dos exemplos nas instruções, por exemplo, fala sobre evidências que um avaliador poderia usar para determinar as dosagens corretas de um medicamento para tratar a pressão alta, chamado Lisinopril.

O Google disse que alguns funcionários preocupados com a precisão do conteúdo podem não ter sido treinados especificamente para tal, mas para o tom, a apresentação e outros atributos que ele testa.

"As classificações são deliberadamente realizadas em uma escala móvel para obter um feedback mais preciso para melhorar esses modelos", disse a empresa. "Essas classificações não afetam diretamente o resultado de nossos modelos e não são, de forma alguma, a única maneira de promovermos a precisão."

Ed Stackhouse, o funcionário da Appen que enviou a carta ao Congresso, disse em uma entrevista que os funcionários contratados estavam sendo solicitados a fazer o trabalho de rotulagem de IA nos produtos do Google "porque somos indispensáveis para a IA no que diz respeito a esse treinamento".

Supervisão automatizada

Mas ele e outros funcionários disseram que pareciam estar sendo avaliados por seu trabalho de forma misteriosa e automatizada. Isso porque eles não têm como se comunicar diretamente com o Google, além de fornecer feedback em uma entrada de "comentários" em cada tarefa individual. E eles precisam ser rápidos.