Proposta do governo Lula para obrigar plataformas a reduzir conteúdo golpista preocupa especialistas

Avaliação é que medida pode incentivar remoção de conteúdos legítimos; pesquisadores citam ainda risco em redes precisarem interpretar Lei do Estado Democrático de Direito

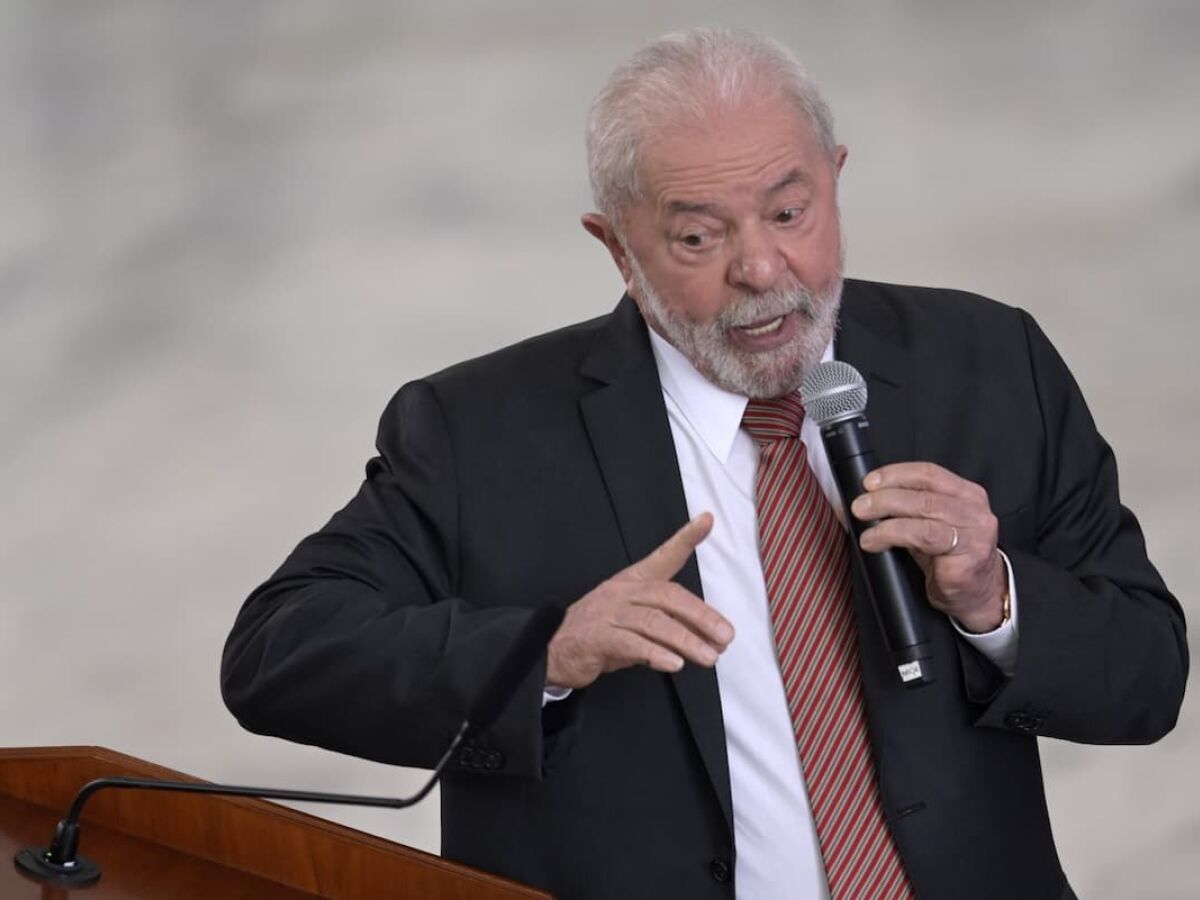

A iniciativa do governo do presidente Luiz Inácio Lula da Silva (PT) de apresentar, após o ato golpista de 8 de janeiro, uma proposta de lei com obrigações para as plataformas de internet impedirem conteúdo em violação à Lei do Estado Democrático de Direito gerou dúvidas e preocupação entre especialistas da área ouvidos pelo Globo pela ausência de informações mais detalhadas.

O texto ainda está em formulação e, segundo o ministro da Justiça, Flávio Dino, será aprofundado junto com as demais medidas do “pacote pró-democracia”.

O conteúdo da proposta foi antecipado pelo jornal “Folha de S. Paulo” e confirmado pelo Globo. O projeto estabelece que as plataformas digitais terão o “dever de cuidado” de impedir que se dissemine conteúdo que viole a lei, como pedido de abolição do Estado democrático de Direito, ou aquele que encoraje a violência para deposição do governo e incite, publicamente, animosidade entre as Forças Armadas e os Poderes constitucionais.

O governo argumenta que as redes sociais foram a principal ferramenta para a convocação dos ataques golpistas. Pela proposta, que será submetida ao Congresso, as plataformas que não cumprirem a determinação serão multadas. O modelo proposto se baseia na “Lei de Fiscalização da Rede” que vigora na Alemanha desde 2017.

Embora haja consenso para a necessidade de impedir a circulação de conteúdo ilegal, há diferentes caminhos para se cobrar o chamado “dever de cuidado”, princípio que tem inspiração em regulações europeias. Para o advogado Francisco Cruz, diretor-executivo do centro de pesquisa InternetLab, um dos pontos é entender se a via será a da transparência, ou da remoção proativa de conteúdo:

— Ainda não dá para entender quais são as obrigações. Publicar relatórios de transparência com periodicidade é uma coisa. A criação de um dever de cuidado também pode vir acompanhada, e frequentemente foi, de detecção proativa de conteúdo ilegal e isso cria eventuais incentivos para mais remoções. Outro caminho é construir um canal de notificação de conteúdo ilegal, de denúncias, e prestar contas sobre o que foi feito com as denúncias.

Outra dúvida levantada por Francisco Cruz é se vai existir algum órgão regulador que vai acompanhar o cumprimento do dever de cuidado no dia a dia, ou se essa será uma atribuição do Judiciário. Um cenário problemático, na sua avaliação, é se as plataformas tiverem que interpretar o que é ilegal perante a lei brasileira. Outro ponto é o risco de se levar a um sistema de incentivo que pode acarretar na remoção de conteúdo legítimo.

— Elas podem interpretar os próprios termos de uso, prevenir conteúdos que causam danos. Só que ao dizer à plataforma que ela vai remover conteúdo ilegal ou vai levar multa, na dúvida, vai remover qualquer coisa que fique nessa margem. Por mais que tenha alguns crimes muito claros, explícitos, tem outros que são mais desafiadores de interpretar. Um exemplo é o crime de incitar a animosidade das Forças Armadas. Interpretar o que é incitar não é simples. A gente vai querer transferir para a plataforma a obrigação de interpretar esse artigo? — questiona.

Pesquisadora visitante no Centro de Ciências Sociais de Berlin (WZD), Bruna Santos afirma que, na Alemanha, país citado como parâmetro, houve uma opção por um arranjo mais complexo do que apenas listar que conteúdos devem ser removidos:

— Existe uma compreensão de que a escala dos conteúdos pode ser grande. Para isso, as plataformas também estabelecem procedimentos para que seus usuários denunciem conteúdos e são feitos relatórios de transparência.

Para Santos, é preciso uma definição, no Brasil, sobre o que deve ser enquadrado como ilegal, sobre qual autoridade vai dizer o que é conteúdo ilegal e sobre qual o cuidado específico que as plataformas devem tomar, se remoção ou, por exemplo, redução de alcance.

— A linguagem é subjetiva, embora algumas questões envolvendo os crimes sejam mais claras. Além disso, as táticas e estratégias também foram se sofisticando para não serem enquadradas como crime que atente contra ordem democrática. Tivemos, por exemplo, a festa da Selma sendo usada para chamar para os atos. Vai ter que existir um exercício de acompanhamento para entender se aquele conteúdo se encaixa no crime ou não. É uma equação complicada.

Integrante da Coalizão Direitos na Rede, Renata Mielli, que fez parte do grupo de transição de comunicações do governo, diz que há uma preocupação inicial com o que tem sido divulgado sobre a proposta. A pesquisadora defende que a atual gestão precisa considerar o acúmulo de debate público e no Congresso sobre o tema, como o Projeto de Lei 2630, chamado de PL das Fake News, que trata da regulação das plataformas.

Um dos pontos centrais, na sua avaliação, é a necessidade de estabelecer parâmetros de transparência, num cenário em que as decisões de moderação são opacas, para que seja possível definir se as plataformas estão ou não cumprindo seu dever. Ela concorda ainda que as plataformas podem remover conteúdos legais para evitar que sejam impostas multas por suposto descumprimento do seu dever.

— A depender do tom e termo usados, uma crítica legítima pode ser derrubada por decisão automatizada — pondera Renata Mielli. — O 8 de janeiro acelerou a ansiedade de se produzir respostas, mas não existe resposta simples. Tentar propor medidas legislativas num curto espaço de tempo, desconsiderando o debate no Congresso e entre especialistas, pode gerar mais consequências negativas que positivas. Todos somos favoráveis a enfrentar o fenômeno, mas é preciso tomar cuidado. Não deveríamos estar com tanta pressa de apresentar pacotes de lei, que podem ser problemáticas, num momento delicado.